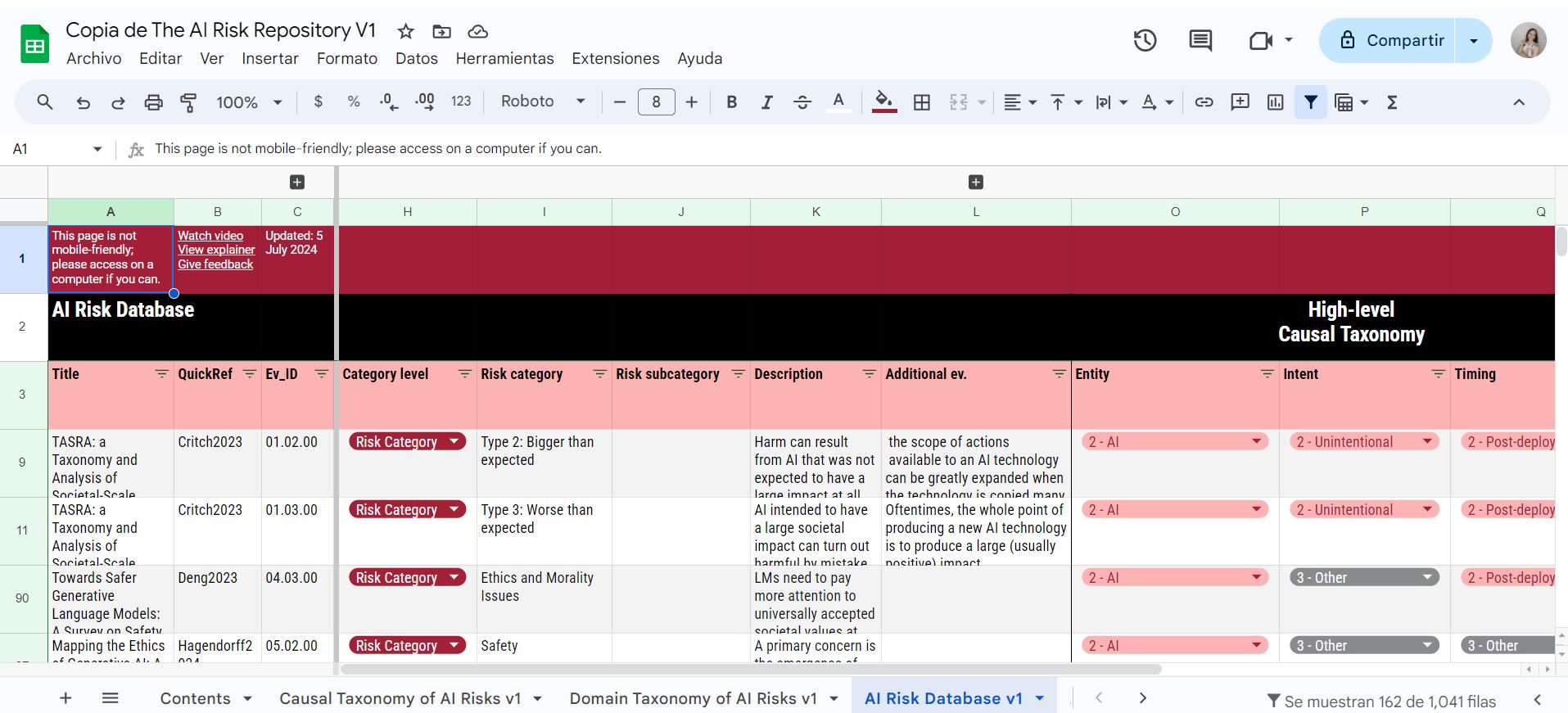

El Instituto de Tecnología de Massachusetts (MIT) ha creado un repositorio que documenta más de 777 riesgos asociados con la inteligencia artificial. Esta base de datos se organiza en 43 categorías, tales como desinformación, alucinaciones y ciberataques.

Los riesgos se pueden filtrar según dos taxonomías generales y se pueden acceder, modificar y actualizar fácilmente a través del sitio web (https://airisk.mit.edu/) y una hojas de cálculo de Google Sheets pública.

El repositorio ofrece una base de datos detallada y categorizada para abordar la falta de un entendimiento común sobre los riesgos de la IA, la cual “puede obstaculizar” la capacidad de académicos, auditores, legisladores, empresas de IA y el público en general para discutir, investigar y responder de manera integral al tema.

Cuáles son los riesgos de la IA según el MIT

Se realizó una primera clasificación de los riesgos de inteligencia artificial mediante una Taxonomía de Riesgos de IA por Dominio. Esta clasificación identifica siete áreas clave:

- Discriminación y toxicidad

Se refiere a cómo los modelos de inteligencia artificial pueden perpetuar estereotipos sociales y fomentar discriminación injusta. Esto ocurre cuando dichos modelos reproducen o amplifican lenguaje discriminatorio, generando desigualdades en el trato o en el acceso a recursos basadas en características sensibles como sexo, religión, género, orientación sexual, capacidad y edad.

- Privacidad y seguridad

Aborda los riesgos asociados con la generación de contenido por parte de los modelos de inteligencia artificial que puede incluir información personal sensible, un fenómeno conocido como filtración de privacidad. Esta situación puede resultar en la exposición no autorizada de datos privados, lo cual representa una amenaza considerable para la seguridad y privacidad de los usuarios.

- Desinformación

Estos daños incluyen la propagación de desinformación, contaminación, agotamiento de recursos, enfermedades mentales o injusticias, afectando negativamente a la sociedad.

- Actores malintencionados y uso indebido

Hace referencia al riesgo de que la inteligencia artificial sea utilizada por personas o grupos con intenciones dañinas para causar perjuicio a gran escala.

- Interacción humano-computadora

La quinta categoría, interacción humano-computadora, examina los riesgos asociados con la influencia negativa de la inteligencia artificial sobre los usuarios. Si un modelo de lenguaje (LM) promueve comportamientos o puntos de vista éticamente cuestionables, podría incentivar a los usuarios a realizar acciones perjudiciales que no habrían contemplado por sí mismos.

Este problema es particularmente alarmante cuando la IA se percibe como una autoridad o asistente confiable, ya que puede inducir a comportamientos dañinos sin que el usuario tuviera esa intención inicial.

- Daños socioeconómicos y ambientales

La categoría, daños socioeconómicos y ambientales, se refiere al impacto negativo de la inteligencia artificial en la sostenibilidad y el medio ambiente.

- Seguridad, fallos y limitaciones de los sistemas de IA

La séptima categoría, seguridad, fallos y limitaciones de los sistemas de IA, se refiere a los riesgos asociados con ataques que explotan vulnerabilidades en la inteligencia artificial para maximizar el consumo de energía y afectar el rendimiento del sistema.

Quiénes se involucraron en la creación del repositorio

Para desarrollar el repositorio, los investigadores del MIT colaboraron con expertos de la Universidad de Queensland, el Future of Life Institute (una organización sin fines de lucro), la KU Leuven y la startup de inteligencia artificial Harmony Intelligence. Juntos, exploraron bases de datos académicas y recopilaron miles de documentos relacionados con la evaluación de riesgos de la inteligencia artificial.

“Se trata de un intento de seleccionar y analizar rigurosamente los riesgos de la IA en una base de datos de riesgos públicamente accesible, completa, extensible y categorizada que cualquiera pueda copiar y utilizar, y que se mantendrá actualizada con el tiempo”, comentó Peter Slattery, investigador del grupo FutureTech del MIT y líder del proyecto del repositorio de riesgos de la IA, a TechCrunch.

“Lo creamos en este momento porque lo necesitábamos para nuestro proyecto y nos dimos cuenta de que muchos otros también lo requerían”, agregó.